Índice

AlternarNossos rostos estão se tornando chaves digitais. Eles desbloqueiam telefones, nos permitem embarcar em aviões e nos dão acesso a espaços seguros. O reconhecimento facial está rapidamente se tornando fundamental para provarmos quem somos na era digital.

Mas há uma reviravolta oculta: os sistemas modernos não reconhecem apenas a identidade - eles também podem inferir emoções. Um sorriso, uma careta ou uma mandíbula tensa podem ser classificados em categorias como "feliz", "irritado" ou "nervoso". Para os humanos, esses sinais são efêmeros e muitas vezes ambíguos. Para as máquinas, eles correm o risco de se tornarem pontos de dados permanentes, armazenados e analisados sem contexto.

É aí que entra o trabalho do Dr. Alejandro Peña - PhD em Deep Learning e Responsible AI, engenheiro de telecomunicações e membro da equipe de pesquisa do Identy.io. Em 2020, junto com colegas da Universidade Autônoma de Madri e do MIT, ele fez uma pergunta provocativa: Podemos criar sistemas de reconhecimento facial que identifiquem as pessoas ignorando as emoções?

A ideia central: reconhecimento "cego pela emoção

Mais reconhecimento facial Os sistemas de reconhecimento facial são treinados para identificar pessoas. No entanto, sem querer, eles também capturam traços ocultos de nosso estado emocional. Isso significa que um sistema projetado para permitir que você desbloqueie seu telefone poderia, em teoria, também detectar que você está cansado ou estressado.

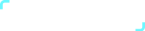

A equipe de Peña explorou se a verificação de identidade poderia permanecer precisa se as informações emocionais fossem removidas. Eles testaram duas abordagens:

- SensitiveNets: Imagine ensinar um aluno a se concentrar apenas nos nomes em uma foto da turma e ignorar todo o resto. O SensitiveNets "desaprende" detalhes emocionais e, ao mesmo tempo, preserva a precisão da identidade, do gênero e da etnia.

- Aprender a não aprender: Essa abordagem é como dar uma penalidade a um aluno toda vez que ele presta atenção às emoções em vez de à identidade. O sistema é treinado para ignorar ativamente os sentimentos nos dados.

Os resultados foram claros: os sistemas mantiveram alta precisão (acima de 95%) para verificação de identidade, gênero e etnia, mas sua capacidade de detectar emoções caiu em mais de 40%. Isso provou que a privacidade pode ser projetada na IA, excluindo detalhes desnecessários e confidenciais.

Por que isso é importante: Riscos do mundo real

À primeira vista, máquinas que leem emoções podem parecer úteis. Mas, uma vez vinculadas à identidade, os riscos se tornam sérios.

- Monitoramento do local de trabalho: Imagine câmeras avaliando a "motivação" dos funcionários. Uma expressão neutra poderia ser confundida com desinteresse, influenciando injustamente as avaliações de desempenho

- Educação: A IA nas salas de aula pode medir o "envolvimento". Os alunos que processam as informações em silêncio podem ser penalizados por não "parecerem atentos".

- Segurança: Um viajante nervoso em um aeroporto - talvez simplesmente com medo de voar - pode ser sinalizado como "suspeito" pela IA emocional.

- Marketing: Os outdoors poderiam examinar os transeuntes e adaptar os anúncios com base no humor. Um rosto triste pode acionar anúncios de comida reconfortante ou soluções rápidas, sem que a pessoa perceba que suas emoções foram exploradas.

- Assistência médica e seguros: Os dados emocionais podem ser usados para fazer suposições sobre a saúde mental ou o estilo de vida de um paciente, o que pode afetar a cobertura ou as oportunidades de emprego.

Esses exemplos mostram como os dados emocionais, se mal utilizados, podem reforçar preconceitos, manipular comportamentos ou invadir a privacidade.

Um paralelo histórico: Impressões digitais vs. emoções

Quando as impressões digitais se tornaram padrão para identificação no início do século XX, elas revolucionaram a segurança. Elas são únicas e estáveis, mas não revelam detalhes particulares sobre a personalidade ou o humor. Elas servem a um propósito: verificar a identidade.

As expressões faciais são diferentes. Elas mudam constantemente, variam entre culturas e podem ser mal interpretadas. Um sorriso pode significar felicidade, educação ou até mesmo desconforto. Tratar esses sinais como dados concretos pode simplificar demais as complexas realidades humanas.

O trabalho de Peña defende a manutenção do reconhecimento facial mais próximo das impressões digitais: focado na identidade estável, não em emoções transitórias.

Além da privacidade: Garantindo a justiça

O estudo também revelou como os sinais emocionais podem introduzir preconceitos. Em um experimento, os sistemas treinados para avaliar a "atratividade" favoreceram os rostos sorridentes. Os sorrisos foram tratados incorretamente como indicadores de beleza, dando a certas expressões uma vantagem injusta.

Ao remover os dados emocionais da equação, os pesquisadores reduziram esses vieses e se aproximaram de um tratamento igualitário entre os indivíduos. Isso mostra que a proteção da privacidade não se trata apenas de sigilo - trata-se também de resultados mais justos.

Da pesquisa à relevância no mundo real

Para que a identidade digital seja bem-sucedida globalmente, ela deve ser confiável. Essa confiança depende de limites: a verificação da identidade não deve significar a exposição de estados emocionais. Ao provar que é possível cegar os sistemas para as emoções sem perder a precisão, a pesquisa de Peña oferece um modelo para uma IA mais responsável.

Isso se alinha aos valores fundamentais do Identy.io:

- Privacidade em primeiro lugar - garantindo verificação de identidade não exponha detalhes desnecessários.

- Equidade - projetar sistemas que funcionem igualmente bem em todas as culturas e grupos.

- Inclusão - criação de tecnologia que capacita, em vez de discriminar.

Conclusão

À medida que a inteligência artificial avança, a questão crítica não é mais apenas o que as máquinas podem fazer, mas o que elas devem fazer?

O trabalho do Dr. Alejandro Peña demonstra que é possível projetar um reconhecimento facial que verifique a identidade, deixando as emoções fora da equação. Isso não apenas protege a privacidade, mas também promove a justiça e a confiança. Nossos rostos podem ser públicos, mas nossos sentimentos são pessoais - e a tecnologia deve aprender a respeitar essa linha.

Leia o documento de pesquisa completo aqui: https://arxiv.org/abs/2009.08704 Controle biométrico de identidade por impressão digital

Referências

- ISO/IEC 24745:2011 - Proteção de informações biométricas

- Artigo 9 do GDPR da UE - Categorias especiais de dados pessoais Categorias especiais de dados pessoais

- Comissão Europeia - Diretrizes éticas para IA confiável Diretrizes éticas para IA confiável (2019)

- NIST - PUBLICAÇÃO ESPECIAL DO NIST Publicação Especial do NIST 800-63-3 - Diretrizes de identidade digital.