Índice

ToggleNuestros rostros se están convirtiendo en llaves digitales. Desbloquean teléfonos, nos permiten embarcar en aviones y nos dan acceso a espacios seguros. El reconocimiento facial se está convirtiendo en un elemento clave para demostrar quiénes somos en la era digital.

Pero hay un giro oculto: los sistemas modernos no sólo reconocen la identidad, también pueden inferir emociones. Una sonrisa, un ceño fruncido o una mandíbula tensa pueden clasificarse en categorías como "feliz", "enfadado" o "nervioso". Para los humanos, estas señales son fugaces y a menudo ambiguas. Para las máquinas, corren el riesgo de convertirse en puntos de datos permanentes, almacenados y analizados sin contexto.

Ahí es donde entra en juego el trabajo del Dr. Alejandro Peña, doctor en Aprendizaje Profundo e Inteligencia Artificial Responsable, ingeniero de telecomunicaciones y miembro del equipo de investigación de Identy.io. En 2020, junto con colegas de la Universidad Autónoma de Madrid y el MIT, se planteó una pregunta provocadora: ¿Podemos construir sistemas de reconocimiento facial que identifiquen a las personas ignorando las emociones?

La idea central: el reconocimiento "ciego a las emociones".

La mayoría de reconocimiento facial están entrenados para identificar personas. Sin embargo, involuntariamente, también captan rastros ocultos de nuestro estado emocional. Eso significa que un sistema diseñado para permitirte desbloquear el teléfono podría, en teoría, detectar también que estás cansado o estresado.

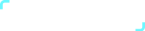

El equipo de Peña estudió si la verificación de la identidad podía seguir siendo precisa si se eliminaba la información emocional. Probaron dos métodos:

- SensitiveNets: Imagine enseñar a un alumno a centrarse sólo en los nombres de una foto de clase e ignorar todo lo demás.SensitiveNets "desaprende" los detalles emocionales al tiempo que preserva la precisión para la identidad, el género y la etnia.

- Aprender a no aprender: Este enfoque es como penalizar a un alumno cada vez que presta atención a las emociones en lugar de a la identidad. El sistema está entrenado para ignorar activamente los sentimientos en los datos.

Los resultados fueron claros: los sistemas mantuvieron una elevada precisión (superior al 95%) en la verificación de la identidad, el sexo y el origen étnico, pero su capacidad para detectar emociones se redujo en más de un 40%. Esto demostró que la privacidad puede diseñarse en la IA excluyendo detalles innecesarios y sensibles.

Por qué es importante: Riesgos reales

A primera vista, las máquinas que leen las emociones pueden parecer útiles. Pero una vez vinculadas a la identidad, los riesgos son graves.

- Vigilancia en el lugar de trabajo: Imagine cámaras que evalúan la "motivación" de los empleados. Una expresión neutra podría confundirse con desinterés, influyendo injustamente en las evaluaciones de rendimiento

- Educación: La IA en las aulas podría medir el "compromiso". Los alumnos que procesen información en silencio podrían ser penalizados por no "parecer atentos".

- La seguridad: Un viajero nervioso en un aeropuerto -quizá simplemente temeroso de volar- podría ser señalado como "sospechoso" por la IA emocional.

- Marketing: Las vallas publicitarias podrían escanear a los transeúntes y adaptar los anuncios en función de su estado de ánimo. Una cara triste podría desencadenar anuncios de comida reconfortante o soluciones rápidas, sin que la persona se diera cuenta de que se aprovechaban sus emociones.

- Sanidad y seguros: Los datos emocionales podrían utilizarse para hacer suposiciones sobre la salud mental o el estilo de vida de un paciente, lo que podría afectar a la cobertura o a las oportunidades de empleo.

Estos ejemplos muestran cómo los datos emocionales, mal utilizados, pueden reforzar prejuicios, manipular comportamientos o invadir la intimidad.

Un paralelismo histórico: Huellas dactilares frente a emociones

Cuando las huellas dactilares se convirtieron en estándar para la identificación a principios del siglo XX, revolucionaron la seguridad. Son únicas y estables, pero no revelan detalles privados sobre la personalidad o el estado de ánimo. Tienen un único propósito: verificar la identidad.

Las expresiones faciales son diferentes. Cambian constantemente, varían de una cultura a otra y pueden malinterpretarse. Una sonrisa puede significar felicidad, cortesía o incluso incomodidad. Si tratamos estas señales como si fueran datos concretos, corremos el riesgo de simplificar en exceso realidades humanas complejas.

El trabajo de Peña aboga por mantener el reconocimiento facial más cerca de las huellas dactilares: centrado en la identidad estable, no en las emociones pasajeras.

Más allá de la privacidad: Garantizar la equidad

El estudio también reveló cómo las señales emocionales pueden introducir sesgos. En un experimento, los sistemas entrenados para calificar el "atractivo" favorecieron las caras sonrientes. Las sonrisas se trataban erróneamente como indicadores de belleza, lo que daba una ventaja injusta a determinadas expresiones.

Al eliminar los datos emocionales de la ecuación, los investigadores redujeron estos sesgos y se acercaron más a la igualdad de trato entre individuos. Esto demuestra que la protección de la intimidad no es solo una cuestión de secreto, sino también de resultados más justos.

De la investigación al mundo real

Para que la identidad digital tenga éxito en todo el mundo, debe ser fiable. Esa confianza depende de unos límites: verificar la identidad no debería significar exponer estados emocionales. Al demostrar que es posible cegar los sistemas a las emociones sin perder precisión, la investigación de Peña ofrece un modelo para una IA más responsable. responsable.

Esto concuerda con los valores fundamentales de Identy.io:

- La privacidad ante todo: garantizar verificación de identidad no revele datos innecesarios.

- Equidad: diseñar sistemas que funcionen igual de bien en todas las culturas y grupos.

- Inclusividad: crear tecnología que potencie, en lugar de discriminar.

Conclusión

A medida que avanza la inteligencia artificial, la cuestión crítica ya no es sólo qué pueden hacer las máquinas, sino qué deben hacer.

El trabajo del Dr. Alejandro Peña demuestra que es posible diseñar un reconocimiento facial que verifique la identidad dejando las emociones fuera de la ecuación. Esto no sólo salvaguarda la privacidad, sino que también promueve la equidad y la confianza. Nuestros rostros pueden ser públicos, pero nuestros sentimientos son personales, y la tecnología debe aprender a respetar esa línea.

Lea el documento de investigación completo aquí: https://arxiv.org/abs/2009.08704 Control biométrico de la identidad mediante huellas dactilares

Referencias

- ISO/IEC 24745:2011 - Protección de la información biométrica

- GDPR de la UE Artículo 9 - Categorías especiales de datos personales

- Comisión Europea - Directrices éticas para una IA digna de confianza (2019)

- NIST - Publicación especial 800-63-3 del NIST - Directrices sobre identidad digital.